過去12ヶ月間(2011年11月から2012年11月)、SEOのプロはSEOに影響を与えるグーグルの大きな変更を目の当たりにしてきた。

過去12ヶ月間(2011年11月から2012年11月)、SEOのプロはSEOに影響を与えるグーグルの大きな変更を目の当たりにしてきた。

目次

今年よく目にした、または耳にしたことが多いワードが、評判と信頼であった。と言っても、SEO業者の評判管理サービスではなく、ウェブサイトのコンテンツ、デザイン、そして、外部リンクにおける信頼である。

設立以来、グーグルおよびその他の検索エンジンは、詐欺的な策略を批判し、一貫した質の高さを推奨してきた。しかし、ここ1年間で、グーグルは今まで以上に効率よく、尚且つ広範囲に渡って、劣悪な行動を取り締まることが出来るようになった。ついに本腰を入れたのだ。

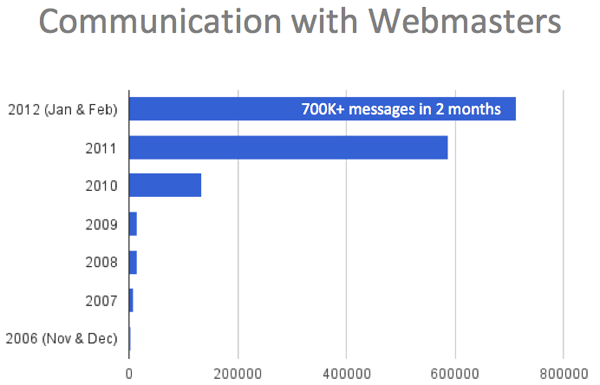

過去、グーグルは、ウェブマスターツールでブラックハットなウェブスパムに関する警告を行ってこなかった。しかし、今年の4月にグーグルが送信するメッセージおよび警告のタイプを拡大したことで、変化が生じた。

「Google、2ヶ月間でウェブマスターツール経由で70万本以上のメッセージを送る」(日本語)を参照にしてもらいたい。

ペンギン

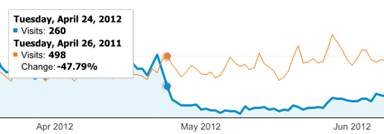

グーグルは、ペンギンを4月24日に導入した。ペンギンは、人為的な外部リンクの兆候を持つウェブサイトにペナルティーを与える。以下の分析スタッフにはペンギンの効果が色濃く表れている。

回復に関しては、ウェブサイトはどれだけリンクが古くても、人為的で質の低いリンクをすべて削除する努力をしなければいけないとグーグルは主張している。グーグルはリンク無効化ツール(日本語)を先月提供していたが、投稿を強い推奨と見なしているため、手っ取り早くスイッチをオフにするツールではない。

また、リンク無効化ツールを使ったとしても、グーグルは急いでサイトの状態を回復するわけではない。事実、グーグルは再びクロールを行い、無効化するまで待つ。スパイダーがサイトの奥深くにあるページ、または質の低いページを訪問するまでに数週間、または数ヶ月間を要することもある。さらに、グーグルは、一部のドメインは修復することが出来ないと指摘する主張を変えていない。

グーグルが信頼することが出来ないリンクを無視している点に注目する必要がある。つまり、スタッツの閾値を超えるまでは、ウェブサイトは幾らかの信頼出来ないリンクを維持することが出来るようだ。また、ペンギンは手動のレビューの代わりではない。そのため、グーグルは、ペンギンが保証したとしても、信用出来ないリンクがあることを理由に、サイトに手動のアクションを行う可能性がある。

パンダ

パンダとは、質の低いコンテンツを多く抱えているウェブサイトにペナルティーを与えるアルゴリズムである。2011年の11月18日以降、グーグルはパンダを13回アップデートしてきた。パンダは、比率に基づいて罰を与える。質の低いコンテンツを削除し、代わりによく練られた有益なコンテンツを掲載したサイトはパンダから回復している。さらに、重複するコンテンツ、または重複に近いコンテンツを組み合わせる、もしくは区別する取り組みを行っているサイトも復帰している。複数の支社に対するページをそれぞれ作り、街、州、住所以外は全てテキストが同じ場合、ペンギンに捕まる可能性がある。

グーグルは質の低さを探すために多くの時間を割いているように思える。そのため、6月 – 7月のウェザーアップデートで質の高いページを特定し、見返りを与える取り組みを行った点は、嬉しい変化と言えるだろう。

ウェブスパム

今年の4月、次のニュースをマット・カッツ氏が発表していた:

今後数日の間に、グーグルはウェブスパムをターゲットにした重要なアルゴリズムの変更を実施する。この変更により、グーグルの既存の品質ガイドラインを違反しているとグーグルが判断したサイトのランキングは下がる。

カッツ氏はクエリの3.1%が影響を受けると推測していたものの、アルゴリズムの仕組みに関しては、明確に示さなかった。あからさまなキーワードスタッフィングが例として挙げられていた。また、2つ目の例として、操作したコンテンツ内のリンクを挙げていた。この点に関して、マット・カッツ氏は次のように説明していた:

この変更の影響を受けるサイトは、徹底的な分析や専門的な技術がなければ、スパムを行っているようには見えないサイトである。しかし、こういったサイトは、ホワイトハットSEOを遥かに超越した取り組みを行っていると言う共通点を持ち、グーグルはこのようなウェブサイトはウェブスパムの手法に手を染め、検索エンジンのランキングを操作していると考えている。

ちなみにこのアップデートには言語分析も含まれているのではないかと私は思っている。

過剰

3月、マット・カッツ氏は、過剰SEO(日本語)に対するアップデートを行うと発表していた。

グーグルはグーグルボットをさらに賢くする取り組み、関連性を改善する取り組みを行っている。また、検索エンジンを乱用したり、大量のキーワードをページに配置したり、過剰な量のリンクを交換したり、通常考えるよりも遥かにうまくいっているサイトも探している。

過剰SEOのペナルティーには何が含まれているのだろうか?この件に関する情報はないが、SEOコミュニティは何となく理解している。この告知を行った際、カッツ氏は、ページにあまりにもキーワードの数が多い点に触れているが、これは以前もカッツ氏が指摘していたポイントである。

今月、カッツ氏はサイトワイドの被リンクの本数に言及し、グーグルが被リンクの本数を数える仕組みと、キーワードの本数を数える仕組みを比較していた。そのため、サイトワイドのリンクは、過剰SEOアルゴリズムに含まれていると推測される。

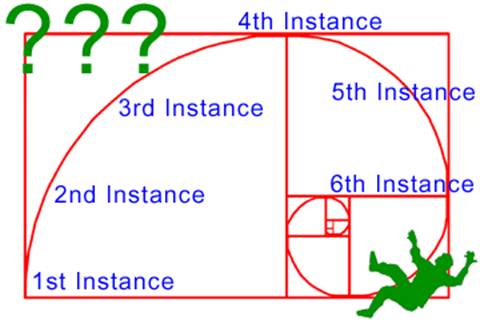

一般的な例を下のイメージで表現してみた。1本は良し、2本はもっと良し、3-4本は最高、そして、数が増えるほどに重要性は徐々に下がり、やがて過剰に到達する。いずれかの時点で過剰の疑いがもたれる。

ちなみに、私はこのコンセプトを説明するため、黄金比と例の本数を任意で選んだ。 キーワードの頻度やリンクの反復等に対するグーグルの本当の公式は分かっていない。閾値も変化するのだろう。重要なのは、グーグルをわざわざ怒らせるような真似はしないことだ。自然な行動を心掛けてもらいたい。

特に興味深く思ったのは、グーグルが一部のアイテムに対してセーフティネットを設けたことだ。ブログロールや支社へのリンク等、正当なサイトワイドのリンクを持っていても、グーグルはペナルティーを与えない。また、これはあくまでも私の推測だが、アルゴリズムのペナルティーの対象にはならなくても、手動のレビューが行われる場合、ピンチを招く取り組みがあるように思える。

完全一致ドメイン

9月、グーグルは質の低い完全一致ドメイン(日本語)を取り締まると発表した。これはパンダやペンギンとは関係なく、コンテンツや外部リンクではなく、TLDが原因で上位にランクインしている完全一致のドメインをターゲットにしている。

上半分に広告が多過ぎる

あまりにも多くの静的な広告をページの上半分に掲載(日本語)し、コンテンツを見るためには下にページをスクロールしなければならないサイトは、ペナルティーを課されるリスクを抱えるようになった。しかし、実際にこのアルゴリズムの影響を受けるサイトは少なく、グーグル曰く、1%以下のようだ。つまり、明らかに分かるサイトのみをターゲットにしていると言えるだろう。

インフォグラフィック & ゲストブログ投稿のリンク

実際のアップデートに関しては分からないが、今年の7月、マット・カッツ氏は、インフォグラフィックのリンクが濫用されているため、ウィジェットの価値を差し引き、ペナルティーを与えたケースと同じように、インフォグラフィックのリンクがウェブスパムチームのターゲットになる可能性があると警告した。

10月、マット・カッツ氏は、ブログおよびゲストブロガーに対して同じような警告を行っていた。ホワイトハットのゲスト投稿は、ブログにとってもゲスト投稿者にとってもメリットがあるが、疑わしいゲスト投稿を実施するとしっぺ返しを食らう可能性がある。

著作権侵害アップデート

評判および信頼におけるグーグルの取り組みの例のトリは、著作権侵害アップデートである。これは、DMCA「削除」要請を多く受けているドメインに対するペナルティー(日本語)である。このアップデートは、グーグルのウェブスパムアルゴリズムとDMCA要請のデータベースを組み合わせた単純なアップデートのように思える。ただし例外が幾つかあるので、上の記事に目を通しておいてもらいたい。

カフェイン

カフェインのインフラが導入されてから数年が経過している。昨年、パンダのおかげで、じっくり挽いたコーヒーを堪能する運びとなった。今年は、ペンギン、サイトワイドのリンク、そして、ページ上半分の過剰な広告の数に対するアルゴリズムが、恐らく、クロールの能力、データ格納の能力、そして、処理能力の高度化の支援を受け、カフェインを活用していたと考えられる。

1年前、グーグルは新鮮さ重視(日本語)のアップデートを行い、検索結果の35%がこのアップデートの影響を受けていた。大幅に改善された「query deserves freshness」アルゴリズムは、最新または再び起きているイベント、注目の話題、そして、頻繁に優れた情報が変わるクエリを識別する。

検索スパイダーがAJAXとJavaScriptを実行することが可能になった点もグーグルの新しい力の一つに数えられる。この告知は、動的に生成されるコメントを読む取り組みを推進する点を重点的に取り上げていたが、この機能は様々な影響をもたらす可能性がある。かつて、JavaScriptの後ろにリンクを隠す行為は一般的に行われていた。これはクローキングやページランクのスカルプティングの典型的な形式であった。しかし、グーグルがこのようなリンクを読むことが出来るなら役に立たなくなる。

マイケル・マルティネス氏は、インラインフレーム化したページが別のページに一意のアンカーの要素をもたらす方法を実証するテストを策定した。この方法はビングでは効果がなかった。また、私個人としては、インラインフレーム化は認められない。iFrameはコンテンツを検索エンジンから隠すために幅広く利用されていた時代があったが、この点もまたグーグルがパワーアップしていることを証明している。

マイリー・オイエ氏は、SMX Advancedでこの点を語っていた。私もなんとなく覚えている。しかし、マット・カッツ氏の最新の動画を見るまでは特に気にしていなかった。 重複するコンテンツと正規化は、SEOの基礎である。

グーグルは、今後、重複するコンテンツのURLを検知/グループ分けし、オーソリティを一つにまとめると宣言している。rel= タグやウェブマスターツールを介してURLの正規化を行う重要性が薄れるわけではないが、動的な重複除外と複数のページのオーソリティをまとめる取り組みは、注目に値するイノベーションだと言えるだろう。

昨年の12月、グーグルはパークドメインを結果から除外するためのパークドメインの分類子を導入した。また、グーグルは、重複するコンテンツを検知して、オリジナルのドキュメントを検索結果に表示する能力を改善した。パークドメインの削除は、テクノロジーの大幅な進化を意味するようには思えないかもしれないが、グーグルの能力が向上している点は間違いない。スクレイパーのサイトにも同じことが言える。すべてのデータは保存され、相互参照に用いられる。

9月、グーグルは検索結果に表示されるドメインの数を増やすためのアップデートを行っていた。本サイトのダニー・サリバンも指摘していたように、グーグルの検索結果は、同じドメインのページに占領されることがある。このアップデートは、このような結果を回避する効果があると思われている。ランキングの選択に新たな処理の層が加わったことになる。

このエントリを終わらせる前に、2つのアイテムについて語らせてもらいたい – それはタグ & SERPのスペースだ。どちらも進化を続けており、そして、どちらも徐々に問題視される傾向にある。

グーグルはタグを推進しており、ウェブマスターならタグの最新情報を把握する必要がある。タグは、コンピュータが解読可能なマークアップとHTMLのエレメントまたはアトリビュートと言う2つの広範な種類に分類される。rel=canonicalやrel=author等のHTMLタグの仕組みは絶対に理解しておく必要がある。このようなタグを利用して、組み込む方法を学んでもらいたい。また、CMSのディベロッパーがHTMLタグを導入するまで徹底的にプッシュしよう。

Schema.org等、コンピュータが解読可能なマークアップを使っているかどうかも重要なポイントの1つである。このタイプのマークアップは、検索エンジンが情報を発見し、分類し、そして、表示しやすくする効果がある。

また、検索エンジンがウェブサイトから情報を取り込み、検索結果内に表示することで、ビジターとトラフィックをもたらす効果も考えられる。マークアップの有無が実際にトラフィックの流れに影響を与えるかどうかについて、熱い議論が交わされている。重要なのは、情報を手に入れ、ウェブサイトにとって適切な判断を下すことである。

昨年、グーグルは、検索エンジンの結果を表示する仕組みにかつてないほどの数の変更を加えていた。最新の変更は、左側のサイドバーを消去し、無料の製品検索を削除するシフト変更である。また、 ローカルの検索結果をもたらすクエリを増やしており、この変更によって利益を得るサイトもあれば、不利益を被るサイトもある。一部のクエリは、10ページではなく、7ページの自然な結果しか表示しない。サイトリンクの数が増え、また、ページ上半分の広告も増えている。次は何が変わるのだろうか?

グーグルは平均的なユーザーのために検索結果を簡素化しつつ、収益の機会を最大限まで活かそうとしているのではないだろうか。典型的なユーザーは、左側の強力なツールがなくなっても気にしないし、新しいドロップダウンメニューを探そうともしないだろう。また、グーグルは、ローカルと友達に力を入れ、結果のパーソナライズ化を推進しようとしている。

[coffee]で検索をかけてみよう。私に対して表示された結果ページの自然なリスティングでは、7つのローカルの結果、そして、3つのパーソナライズドされた結果が掲載されていた。

パーソナライズ、ソーシャル、そして、ローカル – これがグーグルに対するSEOにおいて今後重要になってくる要素である。詳細は来月のコラムで説明する。

この記事の中で述べられている意見はゲストライターの意見であり、必ずしもサーチ・エンジン・ランドを代表しているわけではない。

この記事は、Search Engine Landに掲載された「2012 Year In Review: Important Shifts In Google SEO」を翻訳した内容です。

SEO最新情報やセミナー開催のお知らせなど、お役立ち情報を無料でお届けします。